英偉達(dá)推出新款A(yù)I芯片H200 用于AI大模型的訓(xùn)練

導(dǎo)讀:英偉達(dá)在2023年全球超算大會(huì)(SC23)上推出了一款最新的AI芯片H200,用于AI大模型的訓(xùn)練,相比于其前一代產(chǎn)品H100,H200的性能提升了約60%到9

英偉達(dá)在2023年全球超算大會(huì)(SC23)上推出了一款最新的AI芯片H200,用于AI大模型的訓(xùn)練,相比于其前一代產(chǎn)品H100,H200的性能提升了約60%到90%。

H200是英偉達(dá)H100的升級(jí)版,與H100同樣基于Hopper架構(gòu),主要升級(jí)包括141GB的HBM3e顯存,顯存帶寬從H100的3.35TB/s增加到了4.8TB/s。

在大模型推理表現(xiàn)上,H200在700億參數(shù)的Llama2大模型上的推理速度比H100快了一倍,而且在推理能耗上H200相比H100直接降低了一半。對(duì)于顯存密集型HPC(高性能計(jì)算)應(yīng)用,H200更高的顯存帶寬能夠確保高效地訪問(wèn)數(shù)據(jù),與CPU相比,獲得結(jié)果的時(shí)間最多可提升110倍。

由于架構(gòu)相同,H200將與H100在軟件上相兼容,這意味著H200將具有H100的所有功能。英偉達(dá)宣稱(chēng),H200在大模型Llama 2、GPT-3.5的輸出速度上分別是H100的1.9倍和1.6倍。

英偉達(dá)加速計(jì)算總經(jīng)理兼副總裁伊恩·巴克 (Ian Buck)稱(chēng):“想要通過(guò)生成式AI和HPC應(yīng)用創(chuàng)造智能,就必須使用大型、快速的GPU顯存來(lái)高速、高效地處理海量數(shù)據(jù)。借助H200,業(yè)界領(lǐng)先的端到端AI超級(jí)計(jì)算平臺(tái)的速度將會(huì)變得更快,一些世界上最重要的挑戰(zhàn),都可以被解決。”

過(guò)去,英偉達(dá)數(shù)據(jù)中心AI芯片通常兩年更新一次芯片架構(gòu),最新芯片架構(gòu)是Hopper。不過(guò)英偉達(dá)曾于上個(gè)月向投資人披露,由于市場(chǎng)對(duì)其AI芯片需求旺盛,公司將從每?jī)赡臧l(fā)布一次新架構(gòu)轉(zhuǎn)向每一年發(fā)布一次。 英偉達(dá)還向投資人稱(chēng),其將于2024年發(fā)布基于Blackwell架構(gòu)的B100芯片。

H200將于2024年第二季度出貨。英偉達(dá)稱(chēng),從明年開(kāi)始,亞馬遜云科技、谷歌云、微軟Azure 和甲骨文云將成為首批部署基于H200實(shí)例的云服務(wù)提供商。

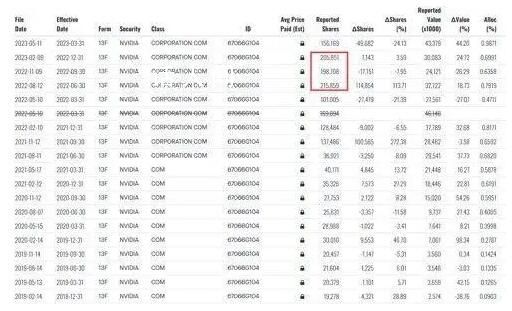

英偉達(dá)股價(jià)在周一美股交易時(shí)段上漲,且已連續(xù)第九個(gè)交易日上漲,創(chuàng)出2016年12月27日以來(lái)的最長(zhǎng)連漲走勢(shì)。今年以來(lái),英偉達(dá)股價(jià)累計(jì)漲幅超過(guò)230%。

-

龍行龘龘 為何生僻字熱起來(lái)了?2024-02-06 18:05:07中國(guó)農(nóng)歷龍年將至,龘字一躍火出了圈,成為生僻字界的扛把子,引起民眾關(guān)注和好奇。為何生僻字又熱起來(lái)了?從中央廣播電視總臺(tái)2024年春節(jié)聯(lián)

龍行龘龘 為何生僻字熱起來(lái)了?2024-02-06 18:05:07中國(guó)農(nóng)歷龍年將至,龘字一躍火出了圈,成為生僻字界的扛把子,引起民眾關(guān)注和好奇。為何生僻字又熱起來(lái)了?從中央廣播電視總臺(tái)2024年春節(jié)聯(lián) -

被困高速3天3夜 小伙稱(chēng)像人在囧途2024-02-06 17:57:352月6日消息,據(jù)國(guó)內(nèi)多家媒體報(bào)道,從杭州駕車(chē)回重慶老家的駱先生,滯留高速公路3天3夜后,終于駛?cè)霑惩范危胰藞F(tuán)聚。駱先生表示:就像

被困高速3天3夜 小伙稱(chēng)像人在囧途2024-02-06 17:57:352月6日消息,據(jù)國(guó)內(nèi)多家媒體報(bào)道,從杭州駕車(chē)回重慶老家的駱先生,滯留高速公路3天3夜后,終于駛?cè)霑惩范危胰藞F(tuán)聚。駱先生表示:就像 -

新郎接親被新娘親友堵樓下要中華煙 目擊者:新郎最終無(wú)奈答應(yīng)2024-02-06 17:54:482月5日,江蘇淮安新郎接親遇女方親友鬧喜,被堵要求發(fā)30條中華煙,目擊者:新郎最終無(wú)奈答應(yīng)。結(jié)婚對(duì)于每個(gè)人來(lái)說(shuō)都是事關(guān)一生的大事,但是

新郎接親被新娘親友堵樓下要中華煙 目擊者:新郎最終無(wú)奈答應(yīng)2024-02-06 17:54:482月5日,江蘇淮安新郎接親遇女方親友鬧喜,被堵要求發(fā)30條中華煙,目擊者:新郎最終無(wú)奈答應(yīng)。結(jié)婚對(duì)于每個(gè)人來(lái)說(shuō)都是事關(guān)一生的大事,但是 -

外國(guó)醫(yī)生回應(yīng)在武漢機(jī)場(chǎng)跪地救人 機(jī)場(chǎng)可用的儀器設(shè)備和積極的響應(yīng)令人印象深刻2024-02-06 17:53:035日,武漢天河機(jī)場(chǎng)一老人突發(fā)心臟病,一外國(guó)醫(yī)生伸出援手急救。外國(guó)醫(yī)生回應(yīng):機(jī)場(chǎng)可用的儀器設(shè)備和積極的響應(yīng)令人印象深刻。2月5日中午12

外國(guó)醫(yī)生回應(yīng)在武漢機(jī)場(chǎng)跪地救人 機(jī)場(chǎng)可用的儀器設(shè)備和積極的響應(yīng)令人印象深刻2024-02-06 17:53:035日,武漢天河機(jī)場(chǎng)一老人突發(fā)心臟病,一外國(guó)醫(yī)生伸出援手急救。外國(guó)醫(yī)生回應(yīng):機(jī)場(chǎng)可用的儀器設(shè)備和積極的響應(yīng)令人印象深刻。2月5日中午12 -

湖北新郎用8臺(tái)四驅(qū)拖拉機(jī)迎親 對(duì)你的愛(ài)就像拖拉機(jī)爬坡轟轟烈烈2024-02-06 17:43:05近日,道路結(jié)冰導(dǎo)致普通車(chē)輛難以通行,湖北一新郎用8臺(tái)拖拉機(jī)當(dāng)婚車(chē)車(chē)隊(duì)迎娶新娘。網(wǎng)友評(píng)論:對(duì)你的愛(ài)就像拖拉機(jī)爬坡,轟轟烈烈。農(nóng)村道路

湖北新郎用8臺(tái)四驅(qū)拖拉機(jī)迎親 對(duì)你的愛(ài)就像拖拉機(jī)爬坡轟轟烈烈2024-02-06 17:43:05近日,道路結(jié)冰導(dǎo)致普通車(chē)輛難以通行,湖北一新郎用8臺(tái)拖拉機(jī)當(dāng)婚車(chē)車(chē)隊(duì)迎娶新娘。網(wǎng)友評(píng)論:對(duì)你的愛(ài)就像拖拉機(jī)爬坡,轟轟烈烈。農(nóng)村道路 -

霍建華李凱馨親密合照 感謝林心如的熱情招待2024-02-06 17:33:19霍建華全面開(kāi)啟內(nèi)地營(yíng)業(yè),目前和李凱馨主演新劇《他為什么依然單身》殺青,李凱馨曬出和霍建華以及林心如夫婦的合影,單獨(dú)和霍建華的合影引

霍建華李凱馨親密合照 感謝林心如的熱情招待2024-02-06 17:33:19霍建華全面開(kāi)啟內(nèi)地營(yíng)業(yè),目前和李凱馨主演新劇《他為什么依然單身》殺青,李凱馨曬出和霍建華以及林心如夫婦的合影,單獨(dú)和霍建華的合影引 -

路面結(jié)冰小哥帶哈士奇送外賣(mài) 網(wǎng)友:這只狗的狗糧都是自己賺來(lái)的2024-02-06 17:31:172月3日,湖北地區(qū)遭遇大雪天氣,路面結(jié)冰,給人們的出行帶來(lái)了極大的不便。在這樣的情況下,一位外賣(mài)小哥想出了一個(gè)獨(dú)特的辦法,他帶著一只

路面結(jié)冰小哥帶哈士奇送外賣(mài) 網(wǎng)友:這只狗的狗糧都是自己賺來(lái)的2024-02-06 17:31:172月3日,湖北地區(qū)遭遇大雪天氣,路面結(jié)冰,給人們的出行帶來(lái)了極大的不便。在這樣的情況下,一位外賣(mài)小哥想出了一個(gè)獨(dú)特的辦法,他帶著一只 -

光大證券:A股市場(chǎng)機(jī)會(huì)大于風(fēng)險(xiǎn)2024-02-06 17:29:42光大證券研報(bào)表示,從估值、股債性價(jià)比、換手率、融資交易占比等指標(biāo)來(lái)看,當(dāng)前A股市場(chǎng)或已處于底部位置,疊加當(dāng)前政策積極發(fā)力,以股票型E

光大證券:A股市場(chǎng)機(jī)會(huì)大于風(fēng)險(xiǎn)2024-02-06 17:29:42光大證券研報(bào)表示,從估值、股債性價(jià)比、換手率、融資交易占比等指標(biāo)來(lái)看,當(dāng)前A股市場(chǎng)或已處于底部位置,疊加當(dāng)前政策積極發(fā)力,以股票型E -

直擊湖北高速:有人因暴雪滯留2024-02-06 17:28:24昨晚到今天,湖北全境出現(xiàn)了降雪天氣,部分地區(qū)出現(xiàn)大到暴雪。積雪深度可達(dá)10厘米以上,局部15厘米以上。此輪低溫雨雪冰凍天氣過(guò)程,將持續(xù)

直擊湖北高速:有人因暴雪滯留2024-02-06 17:28:24昨晚到今天,湖北全境出現(xiàn)了降雪天氣,部分地區(qū)出現(xiàn)大到暴雪。積雪深度可達(dá)10厘米以上,局部15厘米以上。此輪低溫雨雪冰凍天氣過(guò)程,將持續(xù) -

武漢暴雪兩只孔雀被凍在墻頂 已成功救下孔雀狀態(tài)良好2024-02-06 16:48:002月4日,武漢園一工人人員清除積雪時(shí)發(fā)現(xiàn)兩只孔雀被凍在墻頂,景區(qū)工作人員回應(yīng):已成功救下,孔雀狀態(tài)良好。2月4日,武漢園博園一工作人員

武漢暴雪兩只孔雀被凍在墻頂 已成功救下孔雀狀態(tài)良好2024-02-06 16:48:002月4日,武漢園一工人人員清除積雪時(shí)發(fā)現(xiàn)兩只孔雀被凍在墻頂,景區(qū)工作人員回應(yīng):已成功救下,孔雀狀態(tài)良好。2月4日,武漢園博園一工作人員